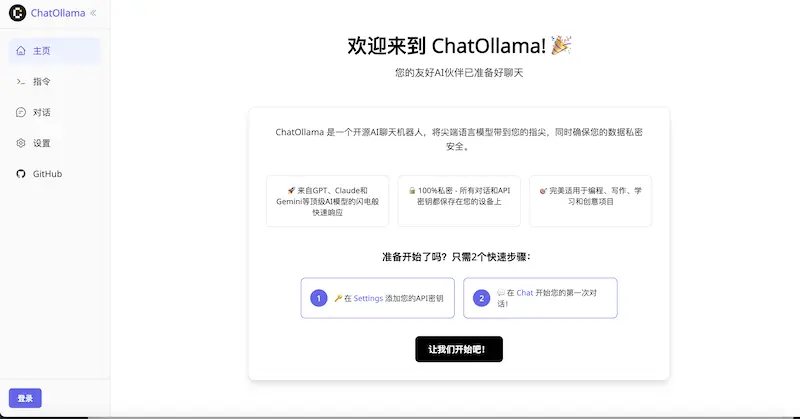

ChatOllama(开源的AI聊天机器人)简介

ChatOllama是一个开源的AI聊天机器人,能够为我们基于AI大语言模型的聊天服务和知识库功能,自行部署能够最大化地确保数据的隐私与安全。该工具使用了Nuxt 3框架进行构建,支持多种主流的AI语言模型,并具备丰富的功能,如知识库、实时语音聊天和模型上下文协议(MCP)集成。

主要功能如下

- Docker支持:用户可以轻松地通过Docker Compose进行部署,快速启动聊天机器人。

- 多模态聊天:ChatOllama支持文本和图像输入,让用户在聊天时可以更灵活地表达自己的想法。

- 知识库:通过检索增强生成(RAG)功能,用户可以上传文档并在对话中引用这些文档,极大地提高了信息的获取效率。

- 实时语音聊天:用户可以与AI进行语音对话,体验更自然的交流方式。

- 模型上下文协议(MCP):通过MCP,ChatOllama可以与外部工具和数据源集成,从而扩展AI的功能。

- 向量数据库支持:支持ChromaDB和Milvus等向量数据库,以便高效管理和存储数据。

ChatOllama(开源的AI聊天机器人)官网及教程

要部署ChatOllama,可以选择两种主要方法:Docker部署和开发环境设置。以下是详细步骤:

方法一:Docker部署(推荐)

- 下载docker-compose.yaml文件:

从GitHub仓库下载docker-compose.yaml文件。 - 运行Docker Compose:

在终端中导航到包含docker-compose.yaml的目录,运行以下命令:docker compose up - 初始化数据库:

第一次运行时需要初始化数据库,运行:docker compose exec chatollama npx prisma migrate dev - 访问ChatOllama:

打开浏览器,访问http://localhost:3000即可使用ChatOllama。

方法二:开发环境设置

- 安装Prerequisites:

确保你的系统已安装Node.js(版本18及以上)和pnpm。 - 克隆仓库:

在终端中运行以下命令:git clone git@github.com:sugarforever/chat-ollama.git cd chat-ollama - 设置环境变量:

复制示例环境文件:cp .env.example .env - 安装依赖:

运行以下命令安装所需依赖:pnpm install - 运行数据库迁移:

运行数据库迁移命令:pnpm prisma-migrate - 启动开发服务器:

启动开发服务器:pnpm dev - 访问ChatOllama:

打开浏览器,访问http://localhost:3000。

额外配置(可选)

- 向量数据库:根据需要配置

.env文件中的向量数据库选项(例如ChromaDB或Milvus)。 - API密钥:如果使用商业模型,可以在

.env文件中添加相应的API密钥。